本文中含有需要您注意的重要提示信息,忽略该信息可能对您的业务造成影响,请务必仔细阅读。

EAS支持将从开源社区下载的模型或您自己训练获得的模型部署为推理服务或AI-Web应用。针对不同方式获取的训练模型,EAS支持不同的部署方式。此外,EAS还提供了一系列针对特定场景的部署方式,您可以通过控制台快速将其部署为在线服务。本文介绍如何使用控制台方式部署及管理服务。

前提条件

已获得训练好的模型。

背景信息

您可以通过控制台部署及管理EAS。

支持自定义模型部署和场景化模型部署两种方式:

自定义模型部署:自定义模型部署提供更灵活的部署方式,您可以通过镜像、模型、processor等方式快速进行AI-Web应用或推理服务的部署。

场景化模型部署:EAS提供了多种针对特定场景的部署解决方案,包括AI绘画-SDWebUI部署、LLM大语言模型、大模型RAG对话系统、AI视频生成-ComfyUI部署、ModelScope模型部署、HuggingFace模型部署、Triton部署和TFServing部署。对于这些不同的部署场景,均提供了简易的部署方法。

EAS支持通过控制台方式管理已部署的模型服务,包括:查看服务详情、更新服务资源配置、更新服务版本、扩缩容等操作。

控制台上传部署

在模型在线服务页面,您可直接将训练完成的模型或开源社区模型部署为在线服务。

步骤一:进入模型在线服务页面

登录PAI控制台。

在左侧导航栏单击工作空间列表,在工作空间列表页面中单击待操作的工作空间名称,进入对应的工作空间。

在工作空间页面的左侧导航栏选择,进入模型在线服务(EAS)页面。

步骤二:选择部署方式

在推理服务页签,单击部署服务。

在部署服务页面,选择并单击相应的部署方式。

部署方式

描述

自定义模型部署

自定义部署

提供更灵活的部署方式。支持通过Processor的形式,或镜像、模型、代码、运行命令和三方库的方式,将您自己的模型部署为在线服务或AI-Web应用。具体的参数配置说明,请参见自定义部署方式参数配置说明。

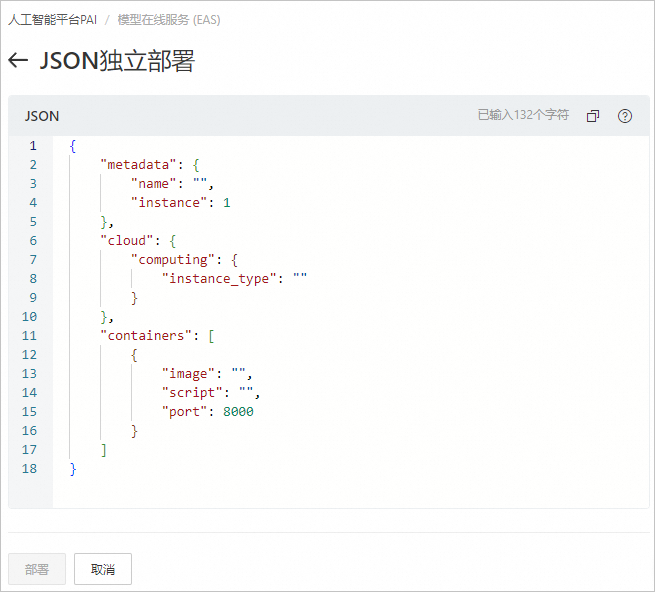

JSON独立部署

根据输入的JSON文件内容来完成模型部署。具体的参数配置说明,请参见JSON独立部署方式参数配置说明。

场景化模型部署

说明关于各个场景的参数配置说明,请参见场景化部署方式参数配置说明。

AI绘画-SDWebUI部署

一键部署基于开源SDWebUI绘画的AIGC服务,提供Web应用和API调用两种部署方式,通过用户与计算资源分离实现企业级应用。

LLM大语言模型部署

一键部署支持WebUI和API调用的LLM应用,您可以利用LangChain框架集成企业知识库,以实现智能问答和自动化功能。通过Blade内置推理加速,实现简单的部署方式及较高性价比的推理方案。

大模型RAG对话系统

一键部署集成了大语言模型(LLM)和检索增强生成(RAG)技术的对话系统服务。适用于问答、摘要生成和依赖外部知识的自然语言处理任务。

AI视频生成-ComfyUI部署

一键部署基于ComfyUI和Stable Video Diffusion模型的AI视频生成服务,帮助您完成社交平台短视频内容生成、动画制作等任务。

ModelScope模型部署

一键部署ModelScope开源模型,快速启动模型服务。

HuggingFace模型部署

一键部署HuggingFace开源模型,快速启动模型服务。

Triton部署

利用基于Trition Server的推理服务引擎,将TensorRT、TensorFlow、PyTorch或ONNX等多种AI框架的模型一键部署为在线推理服务。

TFServing部署

利用基于TensorFlow Serving的推理服务引擎,将Tensorflow标准的SavedModel格式的模型一键部署为在线推理服务。

步骤三:部署服务

根据您选择的部署方式,请参考以下内容配置相应的参数。参数配置完成后,单击部署。等待一段时间,当服务状态变为运行中时,表明服务部署成功。

自定义部署方式参数配置说明

在新建服务页面的模型服务信息区域,配置参数。

服务名称:根据界面提示,自定义服务名称。

部署方式:支持镜像部署服务、镜像部署AI-Web应用、模型+processor部署服务三种部署方式。

说明在复杂的模型推理场景中,例如AIGC、视频处理等场景,推理耗时比较长,需要打开异步服务开关,实现异步推理服务,详情请参见部署异步推理服务。仅当部署方式选择镜像部署服务和模型+processor部署服务时,支持开启异步服务。

镜像部署服务:如果您想通过镜像、代码及模型挂载的方式快速进行AI推理服务的部署,则选择该部署方式。

镜像部署AI-Web应用:如果您想将服务部署为一个AI-Web应用,需要启动一个WebServer,则选择该方式进行部署。

模型+processor部署服务:如果您想通过模型和Processor(包括预置Processor和自定义Processor)进行推理服务的部署,则选择该部署方式。

镜像/镜像AI-Web部署

部署方式选择镜像部署服务和镜像部署AI-Web应用时,参数配置说明如下表所示:

参数

描述

镜像选择

支持以下几种配置方式:

填写模型配置

单击填写模型配置,来进行模型配置。支持通过以下三种方式配置模型文件。

填写代码配置

单击填写代码配置,进行代码配置,支持使用以下几种挂载方式,来读取服务部署过程依赖的代码数据。

OSS挂载

配置OSS源地址路径,即选择OSS Bucket路径。

配置挂载路径,即配置挂载服务实例中的目标路径,用来读取OSS路径中的文件。

NAS挂载

NAS挂载点:配置NAS挂载点地址,EAS服务通过挂载点来访问NAS文件系统。

NAS源路径:需要挂载的NAS中的源路径。

挂载路径:挂载服务实例中的目标路径,用来读取NAS路径中的文件。

Git挂载

Git地址:配置Git代码地址。

挂载路径:挂载服务实例中的目标路径,用来读取Git代码地址中的代码文件。

PAI数据集挂载

选择已创建的数据集,如果没有数据集,您可以单击新建数据集来创建一个新的数据集。

配置挂载路径,即配置挂载服务实例中的目标路径,用来读取PAI数据集。

PAI代码挂载

选择已创建的代码集,如果没有代码集,您可以单击新建代码配置来创建一个新的代码集。

配置挂载路径,即配置挂载服务实例中的目标路径,用来读取PAI代码集。

填写三方库配置列表

单击填写三方库配置列表来配置三方库。支持以下两种方式配置第三方库。

三方库列表:直接在下方文本框中输入三方库。

requirements.txt文件路径:将第三方库写入requirements.txt文件中,在下方文本框中指定该requirements.txt文件的路径。

填写环境变量

单击填写环境变量来配置环境变量。

配置变量名和变量值:

变量名:镜像执行时的环境变量名称。

变量值:镜像执行时的环境变量取值。

运行命令

镜像的启动命令,例如:

python /run.py。同时您需要输入端口号,即镜像启动后监听的本地HTTP端口。

重要由于EAS引擎监听固定的8080和9090端口,因此端口需要避开8080和9090端口。

模型+processor部署

部署方式选择模型+processor部署服务时,参数配置如下表所示:

参数

描述

模型文件

您可以通过以下任何一种方式配置模型文件:

OSS挂载

选择模型文件所在的OSS路径。

上传数据

选择当前地域下的OSS路径。

单击查看本地文件或拖拽上传文件,并根据提示上传本地模型文件。

公网下载地址

单击公网下载地址,并在下方文本框中输入可以公开访问的URL地址。

模型选择

根据模型名称和模型版本选择已注册的模型。关于如何查看已注册的模型,详情请参见注册及管理模型。

Processor种类

支持所有的预置官方Processor和自定义Processor,关于预置官方Processor的更多信息,详情请参见预置Processor使用说明。

模型类别

当Processor种类选择EasyVision(CPU)、EasyVision(GPU)、EasyTransfer(CPU)、EasyTransfer(GPU)、EasyNLP、EasyCV时,支持配置该参数。上述每个Processor种类对应的模型类别不同,请根据业务使用场景选择。

Processor语言

当Processor种类选择自定义processor时,支持配置。

支持选择cpp、java及python。

Processor包

当Processor种类选择自定义processor时,支持配置。您可以通过以下任何一种方式配置Processor包:

OSS文件导入。

单击OSS文件导入,并选择文件所在的OSS路径。

本地上传:

单击本地上传。

选择当前地域下的OSS Bucket路径。

单击查看本地文件或拖拽上传文件,并根据提示上传已下载的Processor文件。

系统会将文件上传至当前地域的官方OSS路径,并自动配置Processor包。

说明通过本地上传的方式,可以使系统在模型部署时,快速加载Processor。

公网下载地址。

单击公网下载地址,并在下方文本框中输入可以公开访问的URL地址。

Processor主文件

当Processor种类选择自定义processor时,支持配置。自定义Processor包的主文件。

填写挂载配置

单击填写挂载配置,进行挂载配置,支持以下几种挂载方式。

OSS挂载

配置OSS源地址路径,即选择OSS Bucket路径。

配置挂载路径,即配置挂载服务实例中的目标路径,用来读取OSS路径中的文件。

NAS挂载

NAS挂载点:配置NAS挂载点地址,EAS服务通过挂载点来访问NAS文件系统。

NAS源路径:需要挂载的NAS中的源路径。

挂载路径:挂载服务实例中的目标路径,用来读取NAS路径中的文件。

PAI数据集挂载

选择已创建的数据集,如果没有数据集,您可以单击新建数据集来创建一个新的数据集。

配置挂载路径,即配置挂载服务实例中的目标路径,用来读取PAI数据集。

PAI代码挂载

选择已创建的代码集,如果没有代码集,您可以单击新建代码配置来创建一个新的代码集。

配置挂载路径,即配置挂载服务实例中的目标路径,用来读取PAI代码集。

填写环境变量

单击填写环境变量来配置环境变量。

配置变量名和变量值:

变量名:镜像执行时的环境变量名称。

变量值:镜像执行时的环境变量取值。

在新建服务的资源部署信息区域,配置参数。

参数

描述

资源组种类

支持选择公共资源组或已购买(创建)的专属资源组。如何购买专属资源组,详情请参见使用专属资源组。

说明建议在任务量相对较少、对任务时效性要求不高的场景下使用公共资源组。

实例数

建议配置多个服务实例,以避免单点部署带来的风险。

当资源组种类选择专属资源组时,您需要为每个服务实例配置CPU、内存(MB)和GPU参数。

资源配置方法

仅资源组种类选择公共资源组时,支持配置该参数。支持以下两种配置方式:

常规资源配置

支持选择单个CPU或GPU实例规格。

如果您领取了免费资源包,支持在西南1(成都)、华南2(河源)、华南1(深圳)地域,使用试用活动页签的免费机型,详情请参见新用户免费试用。

性价比资源配置

弹性资源池

仅资源组种类选择专属资源组时,支持配置该参数。

您可以打开开启弹性资源池开关并参考资源配置方法进行公共资源配置,为部署在专属资源组中的服务开启弹性资源池能力。

弹性资源池配置完成后,当服务扩容时遇到机器资源不足时,新扩出来的实例会自动启动在已配置的按量付费的公共资源上,并以按量计费的方式来进行计费;在缩容时会优先缩减公共资源组中的服务实例。更多详细内容,请参见弹性资源池。

系统盘配置

仅资源组种类选择公共资源组时,支持配置该参数。

单击系统盘配置,为EAS服务配置额外系统盘,单位为GB,取值范围为0~2000 GB。EAS免费赠送30 GB系统盘,如果此处配置20 GB,则实际可用的存储空间为:

免费的30 GB+购买的20 GB=50 GB。额外购买的系统盘按容量和使用时长计费,计费详情请参见EAS计费说明。

可选:在专有网络配置区域,配置VPC、交换机和安全组名称参数,为部署在公共资源组中的EAS服务开通VPC高速直连。

网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。

在对应配置编辑区域,显示服务配置的相关信息。您可以根据需要补充一些在界面不支持配置的配置项,详情请参见创建服务。

JSON独立部署方式参数配置说明

参照服务模型所有相关参数说明,准备用于部署服务的JSON文件。在JSON独立部署页面,将JSON文件内容填入JSON文本编辑框中,然后单击部署。

场景化部署方式参数配置说明

以下是您所选部署场景的参数配置说明:

AI绘画-SDWebUI部署

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

版本选择 | 支持选择以下三种版本:

| |

模型配置 | 如果您想使用自行下载的开源模型、微调训练获得的模型,或者您需要保存输出数据到您自己的数据源中、需要进行一些第三方的配置和插件安装等。可以单击添加按钮进行配置。支持以下两种配置类型: | |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 | 选择部署服务所需的实例规格。仅支持使用公共资源组。推荐使用ml.gu7i.c16m60.1-gu30机型(性价比最高)。如果该机型售罄,可以选择其他机型。 | |

专有网络配置(选填) | VPC | 通过配置专有网络,为部署在公共资源组中的EAS服务开通VPC高速直连。 网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。 |

交换机 | ||

安全组名称 | ||

LLM大语言模型部署

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

模型来源 | 模型来源如下:

| |

模型类别 | 选择模型类别。 | |

模型配置 | 当模型来源选择自持微调模型时,需要配置该参数。 支持以下三种配置类型:

| |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 | 选择部署服务所需的实例规格。仅支持使用公共资源组。推荐使用ml.gu7i.c16m60.1-gu30机型(性价比最高)。如果该机型售罄,可以选择其他机型。 | |

专有网络配置(选填) | VPC | 通过配置专有网络,为部署在公共资源组中的EAS服务开通VPC高速直连。 网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。 |

交换机 | ||

安全组名称 | ||

大模型RAG对话系统

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

模型来源 | 模型来源如下:

| |

模型类别 | 选择模型类别。 | |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 |

| |

推理加速 | BladeLLM提供超高性价比的大模型推理加速能力,可帮助您一键享受高并发和低延时的技术优势。目前,部署在A10或GU30系列机型上的Qwen、Llama2、ChatGlm或Baichuan2等系列模型服务,支持启用推理加速功能。支持以下两种加速类型:

| |

向量检索库设置 | 根据您的场景需要,选择FAISS、ElasticSearch、Milvus、Hologres或AnalyticDB作为向量检索库。关于如何创建和配置向量检索库,请参见步骤一:准备向量检索库和步骤二:部署RAG服务。 | |

专有网络配置 | VPC |

|

交换机 | ||

安全组 | ||

AI视频生成-ComfyUI部署

参数 | 描述 | |

基本信息 | 服务名称 | 自定义模型服务名称。 |

版本选择 | 支持选择以下版本:

更多关于每个版本的使用场景说明,请参见背景信息。 | |

模型配置 | 当选择API版或标准版,并通过API进行调用时,需要单击添加按钮,进行模型配置,以便获取推理结果。支持以下两种配置类型:

| |

资源配置 | 资源配置选择 | 推荐使用GU30、A10或T4卡型。系统默认选择,性价比高。 |

ModelScope模型部署

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

选择模型 | 在下拉列表中选择一种可直接部署的ModelScope模型类型。关于各模型更详细的内容介绍,请参见ModelScope官网。 | |

模型版本 | 在下拉列表中选择模型版本。默认为最新版本。 | |

模型类别 | 选择模型后,系统将自动为您匹配相应的模型类别。 | |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 | 选择部署服务所需的实例规格。仅支持使用公共资源组。 | |

专有网络配置(选填) | VPC | 通过配置专有网络,为部署在公共资源组中的EAS服务开通VPC高速直连。 网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。 |

交换机 | ||

安全组名称 | ||

HuggingFace模型部署

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

模型ID | 配置HuggingFace模型ID,例如 | |

模型类别 | 配置HuggingFace模型类别,例如text-classification。您可以参照步骤一找到部署EAS服务时所需的模型类别(TASK)。 | |

模型版本 | 配置HuggingFace模型版本,例如main。您可以参照步骤一查找模型版本。 | |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 | 选择部署服务所需的实例规格。仅支持使用公共资源组。 | |

专有网络配置(选填) | VPC | 通过配置专有网络,为部署在公共资源组中的EAS服务开通VPC高速直连。 网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。 |

交换机 | ||

安全组名称 | ||

Triton部署

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

模型配置 | Triton部署模型需符合特定结构要求,请参照Triton Inference Server镜像部署进行准备。模型准备就绪后,您可以通过以下任意一种方式选择配置类型: | |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 | 选择部署服务所需的实例规格。仅支持使用公共资源。 | |

专有网络配置(选填) | VPC | 通过配置专有网络,为部署在公共资源组中的EAS服务开通VPC高速直连。 网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。 |

交换机 | ||

安全组名称 | ||

TFServing部署

参数 | 描述 | |

基本信息 | 服务名称 | 参照界面提示自定义配置服务名称。 |

部署方式 | 支持以下两种部署方式:

| |

模型配置 | TFServing部署模型需符合特定结构要求,请参照TensorFlow Serving镜像部署进行准备。

| |

资源配置 | 实例数 | 默认为1。建议配置多个服务实例,以避免单点部署带来的风险。 |

资源配置选择 | 选择部署服务所需的实例规格。仅支持使用公共资源组。 | |

专有网络配置(选填) | VPC | 通过配置专有网络,为部署在公共资源组中的EAS服务开通VPC高速直连。 网络连通后,该VPC环境中的ECS服务器等即可通过创建的弹性网卡访问部署在公共资源组中的EAS服务,同时EAS服务也可以访问VPC环境中的其他云产品。 |

交换机 | ||

安全组名称 | ||

管理EAS模型在线服务

您可以在模型在线服务页面的推理服务页签,查看已部署的服务列表,并对目标服务进行停止、启动、删除等操作。

停止或删除模型服务,会导致依赖该服务的相关请求失败,请谨慎操作。

查看服务详情

单击目标服务名称,进入服务详情页面。在该页面查看服务基本信息、服务实例和服务配置等。

在服务详情页面上方,您可以切换至不同的功能页签,以查看服务监控、日志、部署事件等信息。

更新服务资源配置

在服务详情页面,单击资源信息区域的资源配置。更新服务运行的资源,配置方法请参见控制台上传部署。

更新已有服务版本

在推理服务列表中,单击目标服务操作列下的更新服务,参考控制台上传部署配置方法,来更新服务版本。

警告服务更新过程中将暂时中断运行,可能导致依赖此服务的请求失败,请务必谨慎操作。

服务更新完成后,单击当前版本,查看版本信息或切换服务版本。

扩缩容

在推理服务列表中,单击目标服务操作列下的扩缩容,配置实例数,来提高或减少指定模型服务占用的资源。

弹性伸缩

根据业务需求,配置服务以自动调整EAS其占用的资源。具体操作,请参见方式一:通过控制台管理水平自动扩缩容功能。

相关文档

服务部署成功后,您可以通过在线调试功能,来测试服务运行是否正常,详情请参见服务在线调试。

场景化模型部署成功后,您可以调用该服务来验证模型效果,详情请参见EAS使用案例汇总。

关于EAS其他的部署方式,请参见服务部署:Designer或服务部署:EASCMD或DSW。

部署服务、管理服务等EAS相关API,详情请参见EAS。

- 本页导读 (1)

选择已创建的OSS存储目录。

选择已创建的OSS存储目录。