PySpark及Python库使用

更新时间:

本文介绍如何使用阿里云 Databricks数据洞察 Notebook 进行 PySpark 开发。

重要

若要使用其他数据源进行数据开发,需开通相应服务。本示例采用OSS数据源。

步骤一:创建 Databricks数据洞察集群

创建Databricks 数据洞察集群,详情参见创建集群。

步骤二:添加依赖库并安装

根据开发需要,添加相应的依赖库

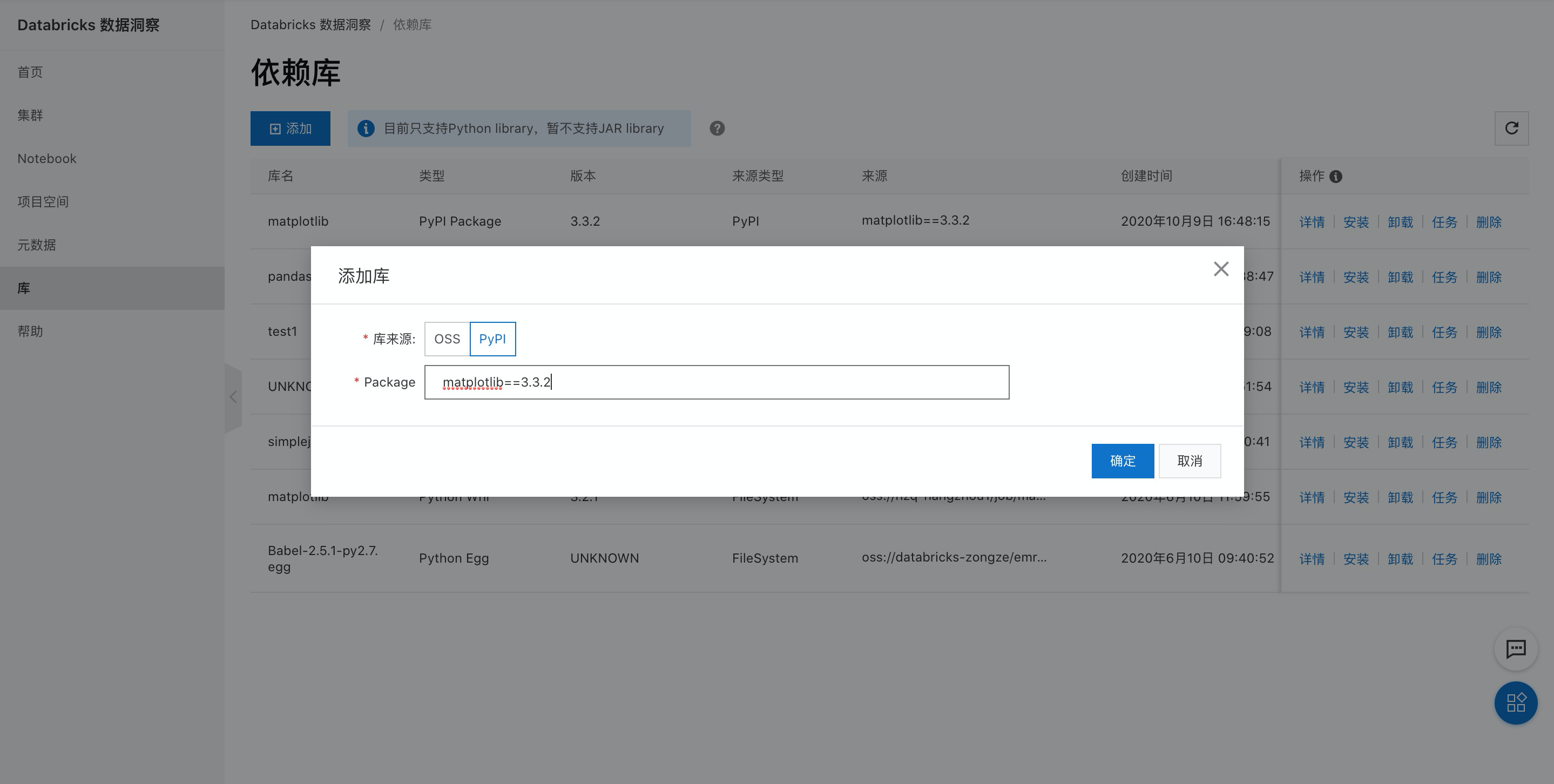

添加matplotlib库,本示例使用PyPI方式添加,详情参见Python库管理。

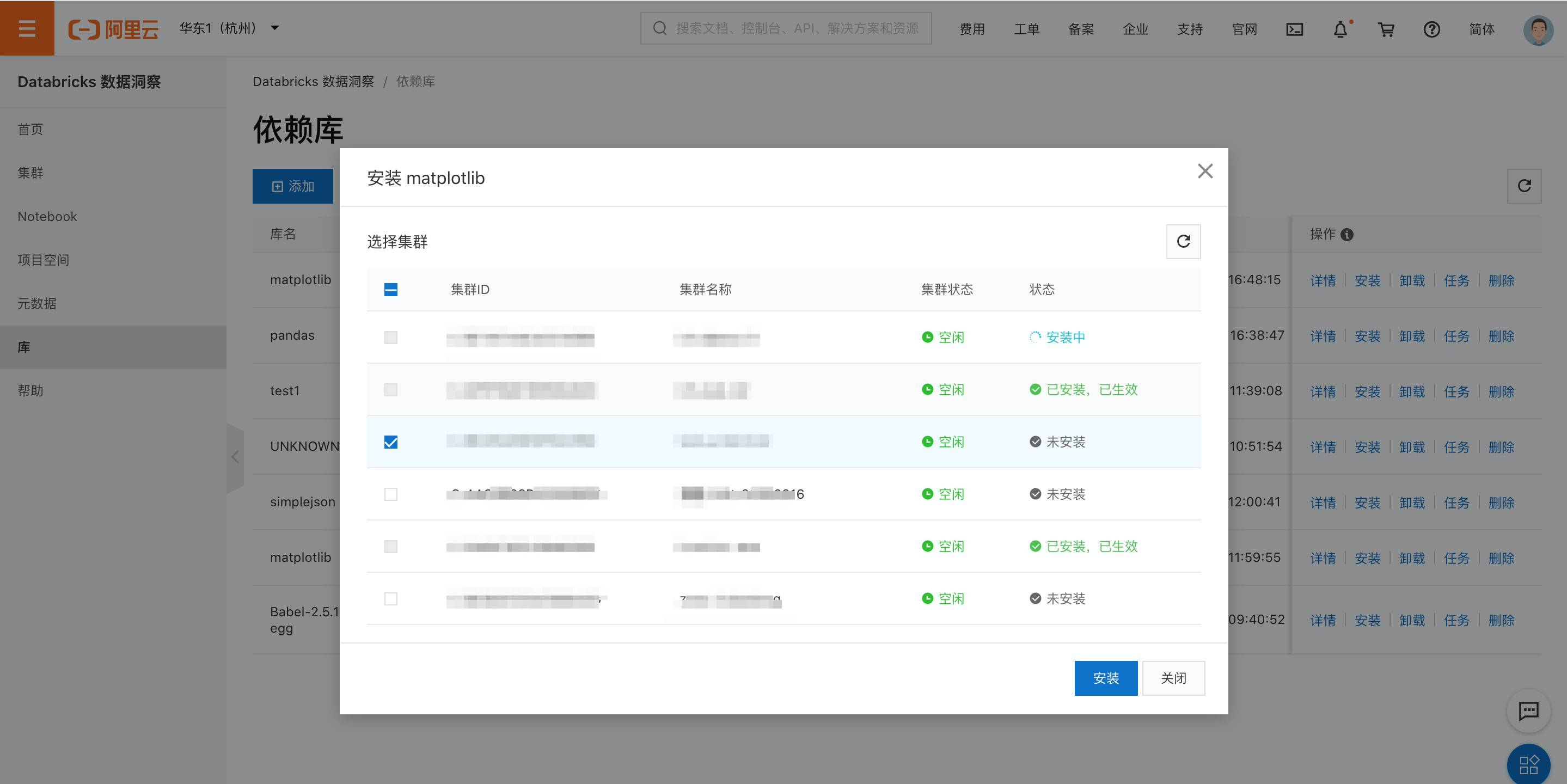

单击安装按钮,安装依赖到开发集群。

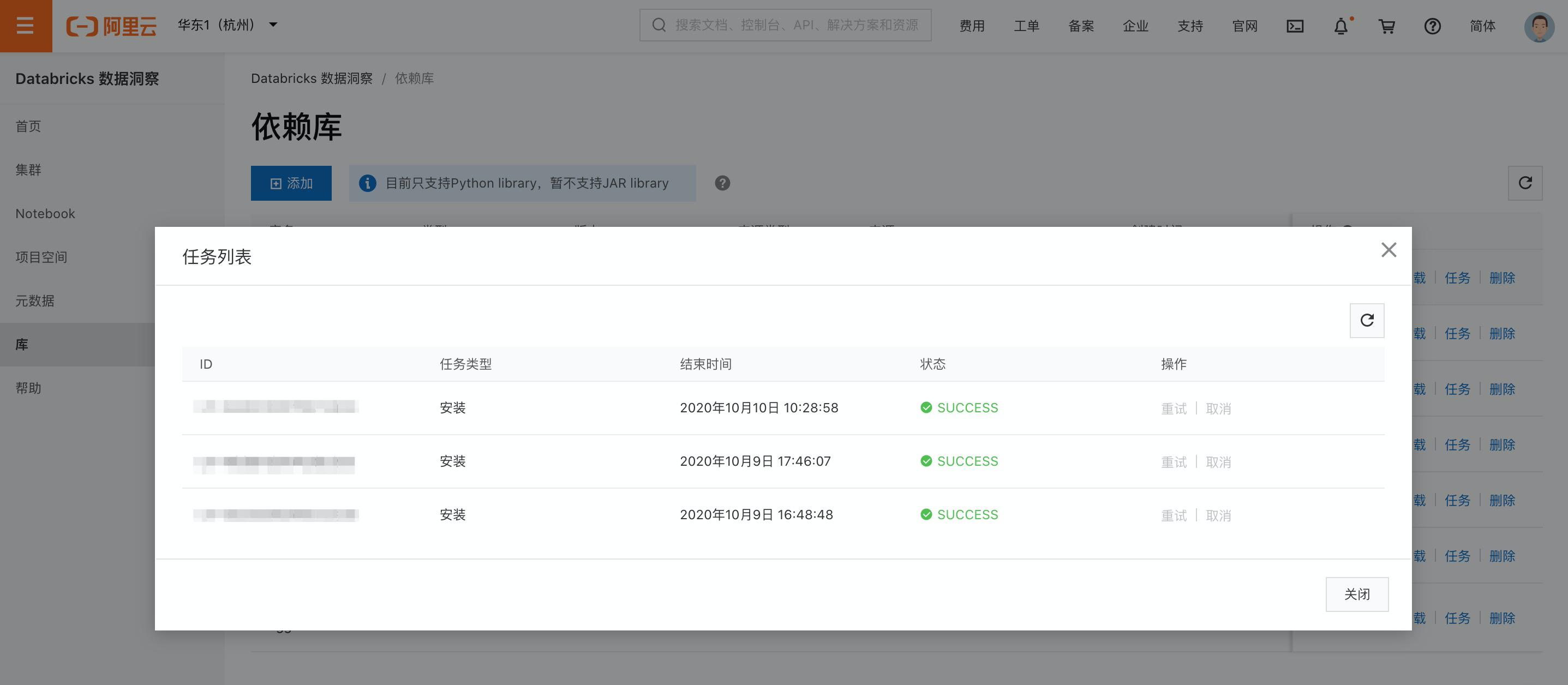

等待安装完成,可单击任务按钮查看。

步骤三:获取数据并上传对象存储 OSS

步骤四:数据开发

Notebook使用,详情参见使用Notebook。

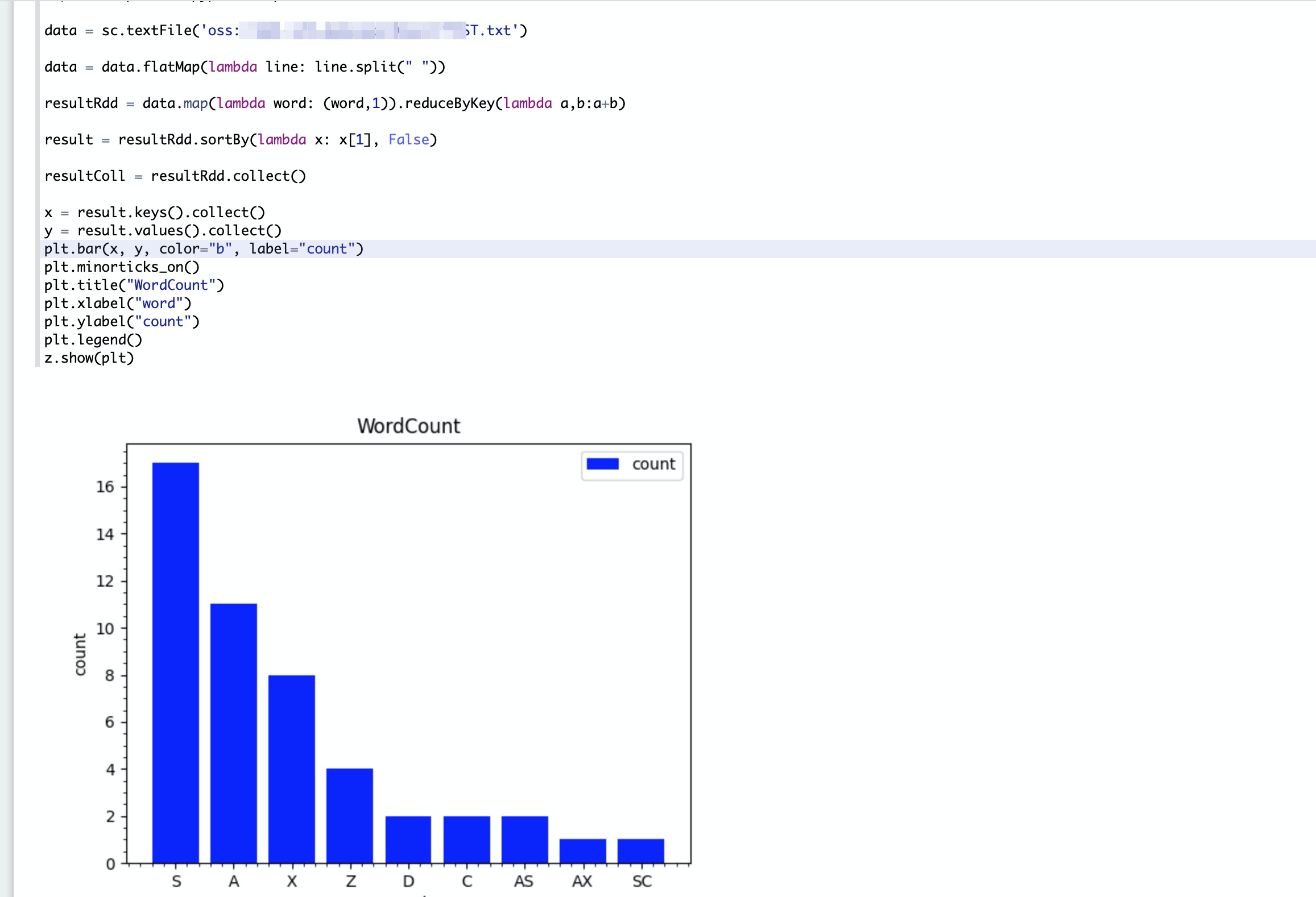

数据开发,将以下代码写入note文件,如下图所示。

%pyspark

import matplotlib.pyplot as plt

data = sc.textFile('oss://xxx/xxx/TEST.txt')

data = data.flatMap(lambda line: line.split(" "))

resultRdd = data.map(lambda word: (word,1)).reduceByKey(lambda a,b:a+b)

result = resultRdd.sortBy(lambda x: x[1], False)

resultColl = resultRdd.collect()

x = result.keys().collect()

y = result.values().collect()

plt.bar(x, y, color="b", label="count")

plt.minorticks_on()

plt.title("WordCount")

plt.xlabel("word")

plt.ylabel("count")

plt.legend()

z.show(plt)单击右上角运行按钮,等待任务结束查看结果

反馈

- 本页导读 (0)

文档反馈